最新ストレージネットワーキング事情

George Crump

Storage Magazine 2014年3月号より

ストレージネットワークは仮想化サーバー環境や高速半導体ストレージに追いつくべく、日々格闘している。ネットワークがボトルネックになり始めているのなら、そろそろアップグレードをする時期にきているのかもしれない。

ストレージネットワークは、仮想化計画やクラスター型データベース導入において、なおざりにされがちな構成要素である。一般的に、プロジェクトにおいて高い優先度をつけられるのは、サーバーや実際に使われるストレージであり、それらをつなぐネットワークではない。昔は、ストレージネットワークが十分すぎるパフォーマンスを提供できていたので、これでよかった。しかし、高密度のサーバー仮想化と半導体ストレージを使ったレイテンシがほぼゼロのストレージの登場により、ストレージネットワークはボトルネックになり始めた。そして、好むと好まざるとにかかわらず、ITプランナーはストレージネットワークをアップグレードする際の選択肢を検討しなければならない。

データセンターの三層構造

データセンターは、三つの層に分けることができる。

・アプリケーションを稼働させる計算レイヤー

・計算レイヤーによって作成されたデータを保存するストレージレイヤー

・計算レイヤーとストレージレイヤーをつなぐネットワーキングレイヤー

仮想化によって単一サーバーが数十個の仮想サーバーをサポートできるようになり、計算レイヤーは大幅にパワーアップした。また、ストレージレイヤーも半導体ストレージのお陰で大幅にレスポンスが良くなった。これらは、データセンターに劇的影響を与えた革新的変化である。ネットワークレイヤーもまた進化してきたが、こちらはパフォーマンスや機能の向上を目的とするよりも、老朽化した機器の更新によって進化してきた。更新は、一般的にはアダプターやスイッチの値段が下がり続けているために徐々に行われてきた。ストレージネットワークは基本的に、データセンターに新規のサーバーが追加された時などのタイミングで、ゆっくり且つ周期的に更新されてきた。

ネットワーク・パフォーマンスの谷間

計算レイヤーとストレージレイヤーにおけるパフォーマンスの画期的な変化によって、ストレージ・ネットワーキングレイヤーがパフォーマンスの谷間になってしまった。計算レイヤーは、おびただしい数でしかもランダムに発生するI/O要求を生成する能力を持ち、一方でストレージレイヤーは半導体ストレージのおかげで、これらの要求に相応の対応ができている。ところが、今まで回転式のハードディスクのレイテンシの蔭に隠れていたネットワーキングレイヤーは、もはや身を隠すものがなくなり、結果的にボトルネックとなってしまった。

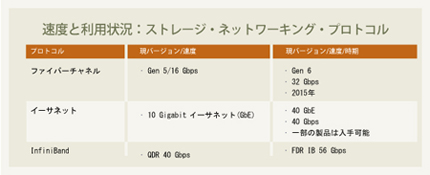

ITプランナーは、突然ストレージネットワークを一気にアップグレードする必要に直面する。しかも選択肢は圧倒的に多い。Gen5 (16Gbps)、ファイバーチャネル (FC)、ファイバーチャネル・オーバー・イーサネット (FCoE)、10 Gigabitイーサネット (10 GbE), 40GbE、InfiniBand、サーバー側でのネットワーキングなどだ。

では、これらのネットワークのそれぞれのタイプが提供する様々な基盤のオプションを比較してみよう。

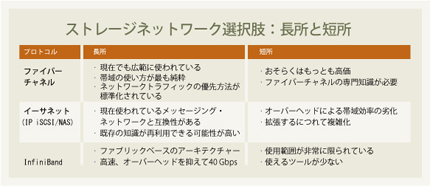

IPネットワーク(10 GbE以上)

IPベースのストレージネットワークは安価で保守が容易だという思い込みのお陰で、インターネット・プロトコル(IP)ベースのストレージネットワークは、ストレージのネットワーク技法としてすごい関心を集めている。色々な選択肢はあるのだが、結局のところ、ほとんどのデータセンターは、既にユーザーとサーバー間の通信やサーバーとサーバーの通信にIPベースのネットワークを使っているからだ。

そのため、IPベースの通信に投資してきた経験と物理的資産を、サーバーとストレージの通信にも活かそうというのが一つの傾向として存在する。IPベースのネットワークには特別なスキルが不要なため、このネットワークを選択する事で、ストレージ基盤の価格と運用コストは下がるはずだ。

既存のIPストレージ・アーキテクチャーでは、その大半をパフォーマンスと冗長性のため、1GbE接続をトランキングやボンディングして使っている。しかし1GbE接続は、今後ベンダーが出荷を停止するかも知れないので、10GbEへの移行は魅力的ではある。とはいえ、10GbEネットワークには、前世代の1GbEネットワークと同じようにネットワーク設計者が知っておくべき問題がある。IPベースのストレージネットワークの問題の一つは、ほとんどのIPアーキテクチャーがいまだにSpanning Tree Protocol(STP)を使っている事だ。STPでは同時に一つの接続しか有効にできない。

STPの弱点は、スイッチが市場に出回るようになる前のイーサネットハブの頃に設計されたというところだ。一般的に、STPはネットワーク上の2点間を結んだ時に、ただ1つのパスだけが有効である事を保証する。ループがないネットワーク基盤を作ることが、この当時の目標だった。

今日のネットワークにおいては、冗長パスは常に存在する。しかし、STPはそれをブロックするか、無効にしてしまう。有効なパスに障害が起きた時、ネットワークは新しいパスを作るためにリコンバージェンス(訳註:再収束とも言う。障害後STPのポートを再度フォワーディングまたはブロッキングを行って、ループしない安定化した状態にする事)しなければならない。大規模ネットワークにおいては、リコンバージェンスに2~3秒の時間がかかる。結果として、本来持っている帯域が無駄に使われるばかりでなく、無効だったパスを有効にしなければならない時、ネットワーク全体が「考え込む」時間を作ってしまう。

1GbEのネットワークで無効なパスを複数持つことは大した問題ではなかった。無駄になる帯域はそれほど大きくなかったし、一つ一つのリンクも非常に安価だったからだ。

しかし10GbEネットワークでは、この問題は非常に目立つようになった。無駄になる帯域が10倍になったのと、一つ一つの接続がかなり高価なためである。

IPネットワークベンダーは、このようにループを回避するためのブロッキングの問題を持たない、ファブリック・ベースのIPネットワークを作ろうとしており、その技術の大半はTransparent Interconnection of Lots of Links(Trill)をベースとしている。しかし、ベンダーごとに実装が異なっており、異機種間の相互運用性はまだ絵に描いた餅だ。さらには、これらを実装したハードウェアは、標準的なイーサネットの競合製品よりもかなり高価だ。

IPネットワークにはSCSI-IP間の変換のオ-バーヘッドがあり、さらにTCP自身が持つオーバーヘッドがある。これらの問題の克服は、IPスタックの負荷を軽減し、IP-SCSI変換を支援する専用ネットワーク・インタフェースカードの使用により可能ではある。しかし、これらのカードをインストールすると、コストが上昇するだけでなく、一見シンプルに見えるIPネットワークの複雑さが増してしまう。

16 Gbps GEN 5ファイバーチャネル

ストレージのプロは大抵、ファイバーチャネルのストレージネットワークを熟知している。ファイバーチャネルネットワークはイーサネットネットワークより高価で複雑だという評判がある。しかしファイバーチャネルはファブリック・ベースのストレージ・トポロジーであり、それゆえにすべてのリンクが有効になっている。このことは、Gen 5 FCの16 Gbpsの帯域が無効になったリンクで無駄にされる事が一切ない、ということを意味する。全てのリンクは有効であり、一つのリンクに障害が起きても、リセット時間が発生することはない。

ファイバーチャネルはまた、損失のないネットワークだ。これは、データが常に送信先に届けられる事を意味し、従ってIPベースのネットワークにあるようなリトライは発生しない。最後に、ファイバーチャネルでは変換を行う必要がない。ファイバーチャネルはSCSIの通信パケットを透過的に扱うからだ。

ファイバーチャネルは、ストレージネットワーキングにおける「保守派」を象徴している。しかし、理論的に可能な機能のほとんど全てを提供しているのはまさにファイバーチャネルのGen 5アーキテクチャーであり、しかも仮想マシン(VM)単位でI/O帯域の優先度を設定する特殊な機能を持っている。

サーバー側ネットワーキング

サーバー側のネットワークは、仮想化基盤の計算レイヤーを構成する複数のサーバーホストに内蔵されたストレージを束ねるために、ソフトウェア定義のストレージを利用することが多い。そこで束ねられたストレージは単一のプールとして共有される。ストレージネットワーキングのこのような形態は、実質的に前述したデータセンターの三層モデルを崩している。とはいえ、この三層がなくなった訳ではない。三つのレイヤーは依然として全て物理デバイス上に、即ち仮想基盤を構成するホスト上に存在している。

サーバー側のネットワーキングは、若干のInfiniBandの使用例はあるにせよ、その大部分をIPベースのプロトコルに依存している。物理ホスト内のCPUパワーによってIP通信で発生するオーバーヘッドが対処されているために、IPベースのプロトコルにおける問題(訳註:前節「IPネットワーク」において述べられた、負荷軽減の為にNICを追加してネットワークの複雑さを増してしまう事など)はかなり解決されている。またSTPのネットワーキング問題も、サーバー間の接続はプライベートで、少数の接続しか必要としないため最小化できるはずだ。

これらのソリューションのいくつかは、束ねたストレージプールのデータをセグメントに分ける。そうすることで、クラスター化された環境で必要とされるデータ保護とデータ共有を提供しているのだ。しかし、セグメント化によってネットワークのレイテンシも起きる。セグメント化によって、サーバー同士を繋いでいるネットワークでの通信が増えるからだ。

いくつかの製品は、仮想マシンのデータをVMが稼働するホストに保存し、それからプールを経由して配布することで、この問題を軽減している。すべての読み込みはローカルサーバーから行われるので、レイテンシがなくなる。書き込みはローカルプールとホスト間のデータを束ねたプールの両方に行われるため、データの安全性と共有が確保される。基本的にこれらのシステムは、より高いパフォーマンスのために、容量の効率性をある程度犠牲にしている。

究極のネットワーキング

INFINIBAND、40 GbE、GEN 6FC

現在選択可能なネットワーキングの中で、さらに極端で素人には近づきがたいのが、InfiniBand、40GbE、Gen 6ファイバーチャネルなどである。後者2つはもともと、現在のIP及びファイバーチャネル標準のアップグレードであり、より大きな帯域を提供するものだ。それに対して、InfiniBandはファイバーチャネル同様フラットなネットワークだ。しかし、こちらは40 Gbpsで稼動する。

InfiniBandは、高頻度取引(訳注:コンピューターと独自のアルゴリズムを持つプログラムを用いて毎秒何百回にも及ぶトレードを自動的に行うこと)などの極度に高いI/Oパフォーマンスを要求する環境でのクラスターノード間接続を行うストレージシステムで広く使われている。またInfiniBandは、HA構成のサーバー間の半導体ストレージをミラーリングする際によく選ばれるネットワークだ。

InfiniBandは、特にサーバー側ネットワークのような多くのストレージネットワーク構成に適用可能だが、広く一般に普及する可能性は低そうだ。あくまで、特殊な使い方をするネットワークの選択肢の一つとして生き残っていくだろう。

究極のネットワーク

少しずつでも次世代ストレージネットワークアーキテクチャーにアップグレードしていかないと、やがて計算レイヤーとストレージレイヤーの投資回収率(ROI)に限界がくる状況に、現在多くのデータセンターが直面しているのは疑いようがない。これらのネットワークが提供する、出来たてで未完成な部分もあるが、パワフルな帯域やその他の機能なしには、仮想化は密度の限界に達し、半導体ストレージは最大限のパフォーマンスを提供できなくなってしまう。

ここで、次世代のストレージ基盤用にどのネットワークを選ぶべきか、という疑問が湧いてくる。ほとんどの場合、それを現在何を使っているかで判断してしまいがちだ。大半の会社は自社で既に持っているトポロジーとプロトコルに執着し、単純にその世代に移行するだけだ。

しかし、ITプランナーは、既設の計算レイヤー、ストレージレイヤーから最大限のROIを引き出してくれる入手可能なアーキテクチャーは何かを考えるべきだ。もしそのアーキテクチャーがより高い密度とより大きなパフォーマンスをもたらすことができるのなら、そこに移行するのに躊躇はいらないはずだ。

著者略歴:George Crumpは、ストレージと仮想化を専門とするITアナリスト企業Storage Switzerlandの社長である。

Copyright 2000 - 2014, TechTarget. All Rights Reserved,

*この翻訳記事の翻訳著作権はJDSFが所有しています。

このページに掲載されている記事・写真・図表などの無断転載を禁じます。

恋塚正隆の連載コラム

恋塚正隆の連載コラム 恋塚正隆の連載コラム

恋塚正隆の連載コラム 恋塚正隆の連載コラム

恋塚正隆の連載コラム JEITA連載寄稿

JEITA連載寄稿 「Storage Magazine」

「Storage Magazine」