ストレージネットワーキング最新動向

著者:Dennis Martin

Storage Magazine 2013年2月号より

仮想化サーバーや仮想化ストレージが多くの注目を集める一方で、この二つをつなぐファブリック技術は見過ごされがちだ。しかし、ストレージネットワーク技術の世界では、常に増え続けるI/Oに対する要求に追いついていくべく、様々な事が起こっている。

ストレージネットワークは、他のデータネットワークの仲間と同じように、大手の企業を対象に慎重かつ徐々に技術を更新していく、漸進型の進化をたどる傾向がある。 一般的なデータセンターが管理するアプリケーションのおびただしい数とこれらのアプリケーションによって激しく行き来するデータが、ストレージネットワークに直接ストレスを与えている。スマートフォンや監視カメラ、無線自動識別(RFID)タグ、その他センサーが付いた無数のデバイスの急増による未曾有のデータ量が、サーバーとクライアントデバイスに繋がっているストレージシステムとストレージネットワーク技術に新たな要求を突きつけている。

新技術がストレージネットワークに与えるストレス

アプリケーションの課題を解決し、データの増大をもたらすことに寄与した技術の中には、サーバー仮想化、半導体ストレージ、新世代サーバーなどの技術がある。非常に異なるもの同士だが、これらの技術にはひとつの共通の特徴がある。これらの技術が、多くのストレージファブリックが提供できない程のI/Oと柔軟なコンフィグレーションを要求している点だ。

| ● | サーバー仮想化 サーバーの仮想化は、今日のIT環境の中に確固たる地盤を築き、物理サーバーあたりの仮想マシン(VM)の数は増え続けている。数年前、1サーバーあたりのVM数は5~10というのが普通だった。多くの場合、この数字は物理サーバーのプロセッサーのコア数と使用可能なメモリー量に基づいて決められていた。最近では、一台の物理サーバーが15個もしくは20個あるいは25個のVMを管理することが普通になってきた。仮想マシンの設置数が増えるにつれて、ストレージネットワークのI/Oも増加している。 |

| ● | 半導体ストレージ 半導体ストレージは、データストレージの著しいパフォーマンス向上をもたらし、我々のラボラトリー・テストでは初めて、ストレージ機器が多くのケースにおいて、もはやデータセンターのボトルネックではないことを示し始めている。これは、良いニュースの方。悪いニュースは、ボトルネックがストレージネットワークの方へと移り始めている、ということだ。 |

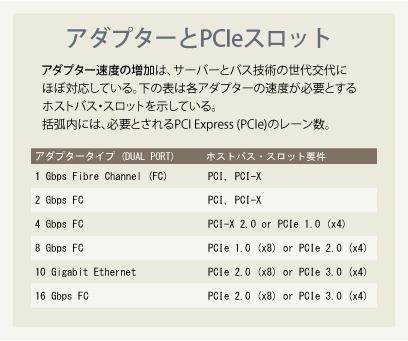

| ● | PCI Express(PCIe)3.0 最新世代のデータセンター・サーバーには、PCIe3.0対応インターフェースが内蔵されている。PCIe3.0は前世代の2倍のバススピードをサポートし、PCIe3.0を内蔵する新型のサーバーは、プロセッサーあたりこれまでの2倍のレーン数を持てるようになったため、結果として、一台のサーバーあたり合計で4倍のI/O帯域幅が使えるようになった。これらの新型サーバーは、ネットワークI/Oの負荷を増大させるが、マザーボード上に10ギガビット・イーサネット(10GbE)を搭載するだけの充分なパワーを持っており、これは今後10GbEがより多く導入され、価格がこなれていくためのワンステップになるものだ。 |

次世代ストレージインターフェース

ネットワーク業界は、既存のネットワーク製品およびプロトコルの機能拡張を行う一方で、増大するI/O問題に対する革新的技術により、これらの要求に応えようとしている。イーサネットやファイバーチャネル(FC)などなじみのあるストレージインターフェースに対しては、より速いスピードが使えるようになるだけでなく、I/Oパスの仮想化というまさにサーバー仮想化を補完する方法も手に入るようになるのだ。

イーサネット

イーサネットはデータ用、ストレージ用双方に幅広く使われているネットワークだ。イーサネットは、Network File System (NFS)やServer Message Blook(SMB、以前はCIFSとして知られていた)のようなファイルストレージ・プロトコルにたいして、優れた運搬手段を提供しており、iSCSIやFibre Channel over Ethernet(FCoE)のようなブロックストレージ・プロトコルにも利用されてきた。10GbEの仕様は2002年に批准され、10年後の時点では10GbEの利用はまだ始まったばかり、といったところだったが、今後間もなく10GbEはイーサネット接続インターフェースの主流となるだろう。最近のストレージ・マガジン/Search-Storage.comストレージ購入調査によると、回答者の28%が自分たちのストレージネットワーク用に10GbEを導入している。(1GbEは30%)。2年前、10GbEを導入していたのはわずかに13%だった。先行して導入された10GbEの使われ方は、スイッチのトランキングに限られており、また、コンポーネントの値段も高かった。2006年に批准された10GBASE-Tの仕様は、慣れ親しんだRJ45タイプのイーサネットを記述しており、これによって10GbEの低価格路線が定まった。10GbE採用増加のもうひとつの原因は、10GbEインターフェースを標準でブレード筐体に内蔵し、低価格な10GbEコンポーネントを提供しているブレードサーバーかもしれない。

10GbEには2つの異なるコネクターのタイプがある。SFP+とRJ45だ。SFP+コネクターの技術は世に出て数年の実績を持つ。回線速度は異なるものの、8Gbpsおよび16Gbpsファイバーチャネル接続と同様の技術が使われている。10GbE SFP+はカッパーでも光ファイバーでも使う事ができる。ダイレクトアタッチカッパー(DAC)として知られるカッパーケーブルは、ケーブルに直接トランシーバーを取り付けることができ、ラック内または近くのラック間のような近距離に向いている。光ファイバーケーブルには一般的にスイッチのケージやアダプターポートに取り付けるトランシーバーが必要だ。光ファイバーは短距離および中距離で使われる。

RJ45コネクターは、Cat5、Cat5e、Cat6のイーサネットケーブルに使われているおなじみのコネクターだ。10GBASE-Tを仕様制限いっぱいの100mの距離で使うときには、Cat6もしくはCat7を使わなければならない。Cat6ケーブルを10GBASE-Tの環境で使う場合、距離の制限は55mだ。Cat5eケーブルは10GbEでは推奨されていない。

10GbEのサーバーについているアダプターは、SFP+コネクターまたはRJ45コネクターをサポートしているが、同一のアダプターで両方のコネクターを同時に使うことはできない。10GbEスイッチもSFP+かRJ45をサポートしている。こちらの場合は、いくつかのモデルは同一のスイッチで両方をサポートしている。

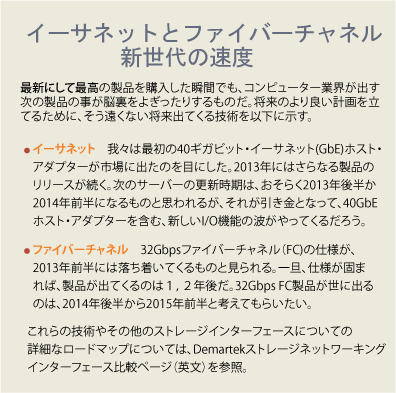

10GbE製品が普及し始めたとはいえ、40GbEと100GbEの仕様が2010年6月に批准されている。これらの技術は今日入手可能ではあるが高価であるため、もっぱらスイッチ間のトランキングやアグリゲーションで使われている。これらの技術は10GbEのレーンを束ねて使うことで速度を倍増している。なお、40GbEは10Gbps(4×10)のレーンを4本使っており、100GbEは10×10の多重化を行っている。

ファイバーチャネル

ファイバーチャネル協議会は、2012年を「10-10-10」の年と呼んだ。累積で1000万台(10million)のFCスイッチとアダプターが出荷され、FC技術に100億ドル(10billion)が投資され、FCのストレージが10エクサバイド(EB)出荷された年だからだ。ファイバーチャネルは、ハイエンドのストレージネットワーク・アーキテクチャーにおいては依然として優位を保っており、エンタープライズ規模の作業負荷、サーバー仮想化、クラウドアーキテクチャーの要求を満たしている。ファイバーチャネルは、信頼性とハイ・パフォーマンスの技術として知られている。

ファイバーチャネルの速度は、1GbpsのFCコンポーネントが市場に初めて登場した1997年以来、3年か4年毎に倍になってきている。現在最も速いのは、16GbpsFCで、2011年にまずスイッチとアダプターに導入された。SANのインターフェースとして、FCは現在もいたって元気に活躍しており、32GbpsFCの開発も既に作業が開始されている。しかし、今日エンタープライズ用ディスクドライブのインターフェースのようなバックエンド用途にはFCはほとんど使われていない。ディスクメーカーがインターフェースをSASに移行したからだ。FCは最低でも2世代前までの互換性を維持しており、16GbpsFCは4 GbpsFCや8 GbpsFCの機器が混在した環境で使用することが可能だ。現在の16 GbpsFCSANのスイッチは2 GbpsFCとも下位互換性を持っている。これは、会社が全体のFC SAN基盤を一気にアップグレードしなくても、アダプター、スイッチ、ストレージシステムを個別にアップグレードできる、という事を意味している。話はハードウェアだけにとどまらない。VMware vSphere5.1とWindows Server2012(Hyper-V付)は、16 GbpsFC特有の機能に対応しており、いくつかの製品は、16 GbpsFCコンポーネントのパッケージドライバーを備えている。これらのハイパーバイザがどちらも、64個の仮想CPUと1仮想マシンあたり1TBのRAMをサポートしていることから、仮想化サーバー環境がI/O帯域の増加を容易に活用できるだろう事は想像に難くない。Windows Server2012 with Hyper-Vは仮想化ファイバーチャネルにも対応している。N_PortID仮想化(NPIV)に対応しているFCホストバスアダプター(HBA)にとって、これはゲストのVMによる仮想化FC HBAへの直接アクセスが可能になることを意味し、仮想マシンに物理マシンと同様のファイバーチャネルにおける機能のサポートとアクセス性を与えることになる。

I/O仮想化

I/Oの通り道を仮想化すると、ネットワークやストレージ・アダプターなどの物理デバイスを複数の論理デバイスとして割り当てる事ができるようになる。また逆に、物理デバイスを組み合わせてより大きな論理デバイスにすることも可能だ。上記のファイバーチャネルの例では、我々は仮想ファイバーチャネルが、複数の仮想FC HBAを仮想マシン環境のゲストに提供するといった、NPIVの活用事例を紹介した。

シングル・ルートI/O仮想化はイーサネット・ネットワーク・インターフェース・カード(NIC)のようなI/Oアダプターを共有するもう一つの方法である。仮想マシン環境において複数のゲストがこれらのNICを共有できるだけではなく、この共有の管理がカード上で処理されるため、ホストのCPU負荷も軽減する。この機能は現在ほとんどのハイパーバイザのイーサネットNICでサポートされている。

ソフトウェア定義のネットワーク

あなたがハイパーバイザを使っているのであれば、あなたはすでにソフトウェア定義のネットワーク(SDN)の一形態を使っていることになる。ハイパーバイザはイーサネットNIC内に仮想ネットワーク・スイッチを作ることによって、サーバーの中にすっぽりとネットワーク・スイッチの機能をおさめる事ができる。一台の物理サーバー上で稼動するゲスト内でのネットワーク活動にとって、これはソフトウェア定義のネットワークの一形態である。最近登場してきたその他のSDNの形態には、ハードウェアとそれを制御する機能を分けるものもある。この機能は、マルチテナント環境間のリソースをプールしなければならないクラウドプロバイダーの関心を集めている。

Open Networking Foundationは、SDNをより前に進めるために業界の先頭に立って活動している。とはいえ、SDNは生まれたばかりで、まだまだ開発しなければならないことがたくさんある。それでも、SDNが提唱する、ネットワークの自動改善管理機能や、ネットワーク技術の革新による速度の増加などの構想は興味深いものがある。

著者略歴:Dennis Martinは1980年からIT業界で仕事をしてきた。コンピューター業界アナリスト団体兼テスト・ラボでもあるDemartekの、創立者兼会長である。

Copyright 2000 - 2013, TechTarget. All Rights Reserved,

*この翻訳記事の翻訳著作権はJDSFが所有しています。

このページに掲載されている記事・写真・図表などの無断転載を禁じます。

恋塚正隆の連載コラム

恋塚正隆の連載コラム 恋塚正隆の連載コラム

恋塚正隆の連載コラム 恋塚正隆の連載コラム

恋塚正隆の連載コラム JEITA連載寄稿

JEITA連載寄稿 「Storage Magazine」

「Storage Magazine」